“Acreditamos profundamente no poder transformador da inovação para enriquecer vidas”,

disse Tim Cook, CEO da Apple.

Rastreamento do Olhar ou, em inglês, Eye Tracking

Para quem não pode usar um teclado físico, o uso do olhar com técnicas de rastreamento do olhar, pode tornar-se uma via para controlar um dispositivo eletrónico. O uso de técnicas de Rastreamento do Olhar é uma prática utilizada por pessoas com deficiências motoras, nomeadamente dos membros superiores, já com alguns anos. No entanto, até hoje, o rastreamento do olhar estava dependente da existência de tecnologias de apoio - hardware ou software.

A grande novidade neste anúncio é a incorporação das técnicas de rastreamento do olhar nos próprios dispositivos da Apple. A partir de agora passa a ser possível a qualquer utilizador interagir com o iPhone e o iPad através do Olhar. Para muitos trata-se de mais uma via de controlar estes dispositivos, para outros esta é mesmo a única via, e tudo isto sem custos adicionais. Está tudo no hardware ou no sistema operativo dos dispositivos. É o poder do mainstreaming!

O Rastreamento do Olhar usa a câmara frontal para, em segundos, se configurar e calibrar, e, recorrendo à função de “machine-readable” do dispositivo, todos os dados necessários à configuração e controlo deste recurso são mantidos, em segurança, apenas no dispositivo - nunca são partilhados com a Apple ou com terceiros.

O Rastreamento do Olhar funciona nas aplicações para iPadOS e iOS. Não necessita hardware ou acessórios adicionais. Com o Rastreamento do Olhar, os utilizadores podem navegar pelos diversos elementos de uma aplicação e usar o “Dwell Control“ (Controlo de Espera) para ativar cada elemento.

O “Dwell Control” (Controlo de Espera) é tradicionalmente usado com um rato ou outro dispositivo apontador e assume que o utilizador não pode tocar ou clicar fisicamente em nada. Quando o utilizador passa o ponteiro sobre um elemento ativável e espera por um determinado período de tempo, ele simula um toque e pode mesmo simular botões físicos, passagem de um dedo pelo ecrã e outros gestos.

Música Háptica - música que se ouve, mas também se sente

Para uma pessoa ouvinte, o conceito “sentir a música” pode soar estranho. Para uma pessoa surda, o conceito pode aproximá-la do universo da música. A acessibilidade vive muito de equivalentes alternativos que permitam aceder à mensagem ou fruir da experiência.

O iPhone tem incorporado um Motor “Táptico” (Taptic Engine) - fusão de retorno háptico e interação por toque - para servir a inovação de funcionalidades “tápticas”. Na verdade é uma tecnologia Apple introduzida pela primeira vez em 2015 nos TrackPads que equipam os MacBook Pro.

O desafio de “sentir a música” por estímulos hápticos leva a tecnologia “táptica” a um limiar altamente exigente - limiar que não é invulgar sempre que se fala em tecnologias de apoio ou tecnologias que tentam incorporar as suas funções.

Quando a música é reproduzida no iPhone, o mecanismo produz toques, texturas e vibrações refinadas para a batida que o utilizador pode sentir. Imagine-se isto aplicado numa cadeira? :-)

Atalhos vocais

Defina um som ou um enunciado e a tarefa será executada de imediato.

O som do estalido de um dedo poderá ser suficiente para (1) rolar a página Web para baixo ou um enunciado do tipo “bute lá” poderá ser suficiente para que a Siri (1) ative o timer e (2) defina uma duração de 20 minutos - geralmente o tempo que uso para colocar uma pizza no forno aqui de casa :-) .

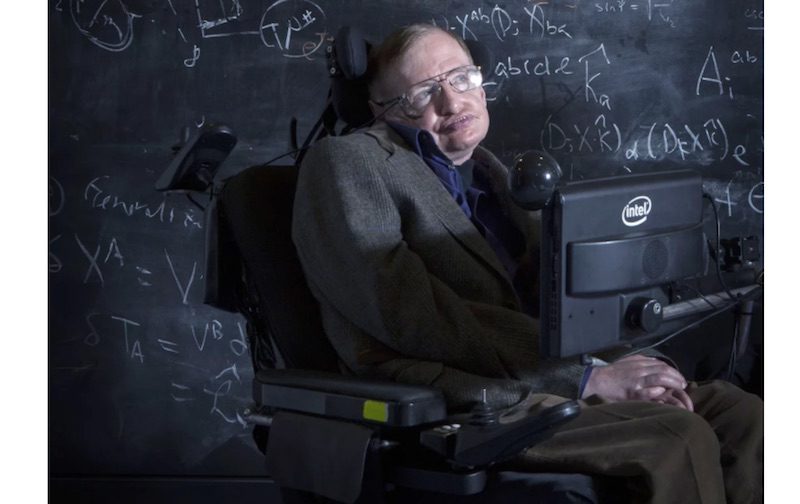

Esta é uma função derivada de uma função maior que é a “Listen for Atypical Speech” (Ouvir Vozes Atípicas). A Apple está a melhorar as capacidades de reconhecimento de fala da Siri com o seu próximo recurso “Listen for Atypical Speech”. Esta ferramenta ajudará a Siri a entender utilizadores com paralisia cerebral, esclerose lateral amiotrófica (ELA), esclerose múltipla (EM), doença de Parkinson, lesão cerebral traumática (TCE), acidente vascular cerebral (AVC) ou outras condições que afetam a fala.

“Listen for Atypical Speech” usa inteligência artificial e machine-learning, existentes nos próprios dispositivos Apple, para reconhecer os padrões de fala de um utilizador. Embora seja óbvio que a Siri beneficiará da inovação nesta área, ela ajudará também outras áreas do iOS e do iPadOS, como é o caso das aplicações de Tradução, Controlo por Voz, e Personalização do Reconhecimento de Voz.

Enjoo provocado pela leitura em veículos em movimento

A ciência é curiosa. O problema existe de facto. Quem nunca se sentiu enjoado a tentar ler quando viaja?

Por exemplo:

"Quando viajo no comboio Alfa Pendular é certinho. Ao fim de alguns minutos de leitura, tragam o saco que estou a sentir que vou vomitar. :-) Geralmente paro, bebo água e a coisa resolve-se. Mas claro, fico com as leituras atrasadas.

Pelos vistos não sou o único. De acordo com várias fontes médicas, uma grande parte da população mundial é suscetível ao enjoar. Os números variam de 25% a 33% e há mesmo os que apontam 65%. Mas nas estatísticas do enjoo :-), há mais uma curiosidade “as pessoas com mais de 50 anos são menos propensas a enjoos provocados pelo movimento.”, mas praticamente qualquer pessoa com mais de dois anos pode enjoar sob estímulos de movimento.

O mais curioso nisto tudo é o porquê que isto acontece e a solução implementada pela Apple no iPhone e no iPad.

Os cientistas dizem que o enjoo é comumente causado por um conflito sensorial entre o que uma pessoa vê e o que sente.

A Apple diz que “Com o ‘Vehicle Motion Cues’, ou seja ativando pontos animados nas margens do ecrã replicando as mudanças de direção do veículo, ajudam a reduzir o conflito sensorial e não interferem na leitura do conteúdo principal.” Para o conseguir, usam sensores integrados no iPhone e no iPad, permitindo ao ‘Vehicle Motion Cues’ reconhecer quando um utilizador está em movimento num veículo e responder em consonância.

Uau!! Seră que resulta? Na minha próxima viagem no Alfa Pendular, vou experimentar… :-)